antoàn.ai là cộng đồng an toàn AI (AI safety) tại Việt Nam.

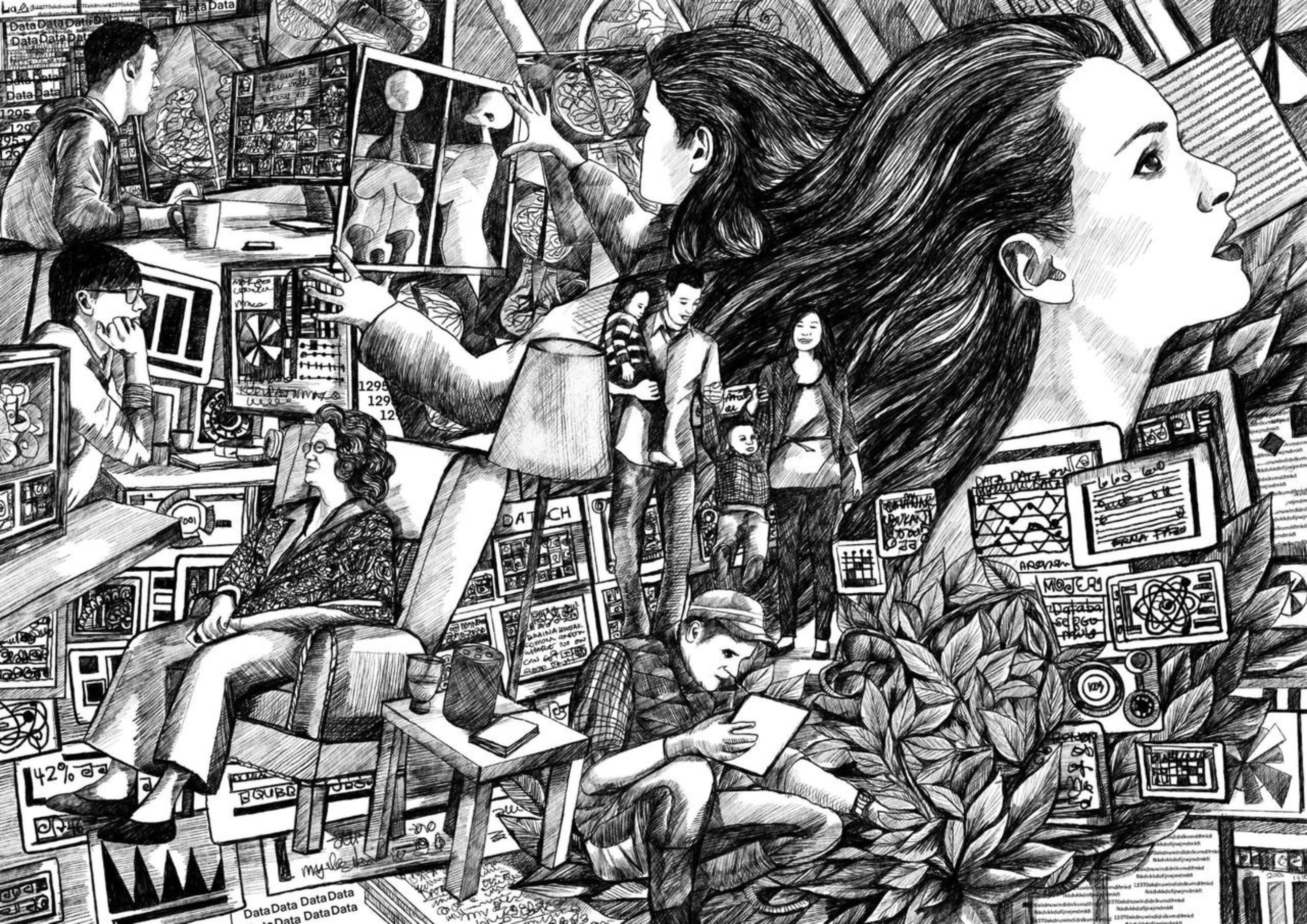

Sứ mệnh của chúng tôi là hỗ trợ và tạo cơ hội cho các học giả, sinh viên, và chuyên gia tại Việt Nam trao đổi và thực hành lĩnh vực an toàn AI, từ kỹ thuật đến chính sách qua các dự án dịch thuật, sự kiện hackathon/nhóm đọc, và thực hành nghiên cứu.

Trí tuệ nhân tạo (AI) ngày càng phức tạp và tự chủ.

AI có tiềm năng mang lại nhiều lợi ích đáng kể cho thế giới, nhưng chỉ khi chúng ta có thể phát triển và sử dụng nó một cách an toàn.

Nhiều vấn đề an toàn AI cơ bản vẫn chưa được giải quyết.

Các công ty đang nỗ lực xây dựng trí tuệ nhân tạo tổng quát (AGI), và các xu hướng cho thấy họ có thể thành công vào năm 2030. Cứ vài tháng một lần, các hệ thống này lại cải thiện khả năng:

Điều này được thúc đẩy bởi sự gia tăng 3 đến 4 lần về khả năng tính toán và hiệu quả thuật toán mỗi năm, cộng với các kỹ thuật huấn luyện mới. Đến năm 2030, chúng ta có thể có AI vượt trội hơn con người ở hầu hết các nhiệm vụ, thậm chí trong việc phát triển chính AI.

Cũng có khả năng cao là AGI sẽ không được phát triển trong nhiều thập kỷ nữa - nhưng khả năng AGI sớm xuất hiện đáng để được xem xét rất nghiêm túc.

Nếu mọi việc diễn ra tốt đẹp, trí tuệ nhân tạo tổng quát (AGI) có thể dẫn đến sự tăng trưởng và đổi mới chưa từng có.

Nhưng nếu mọi việc diễn ra tồi tệ, nó có thể gây ra thảm họa đạo đức, hoặc thậm chí là sự tuyệt chủng của nhân loại.

Chúng ta có thể xây dựng những hệ thống AI cực kỳ mạnh mẽ trước khi hoàn thiện các phương thức kiểm soát cần thiết. Nếu các hệ thống này nắm giữ quyền lực trong khi đi ngược lại giá trị của con người, hệ quả có thể vô cùng nghiêm trọng.

Theo thời gian, khả năng định hình tương lai của nhân loại có thể dần dần bị xói mòn. Nếu các hệ thống AI chiếm lĩnh nhiều quyết định cốt lõi hơn — và nếu mục tiêu của chúng không hướng đến sự phát triển toàn diện của con người — chúng ta có thể dần dần mất đi vai trò chủ động trong những quyết định cốt lõi này, ngay cả khi không có một thời khắc thảm họa cụ thể nào.

AI có thể bị kẻ xấu lợi dụng để sản xuất vũ khí hủy diệt, tạo ra vi khuẩn gây chết người, thực hiện các đợt tấn công mạng tinh xảo, triển khai hệ thống giám sát toàn trị, hoặc phát triển nhanh chóng các công nghệ khác đe dọa sự tồn tại của nhân loại.

AI có thể đẩy mạnh đáng kể những nỗ lực nắm bắt và duy trì quyền lực. Công nghệ giám sát, thao túng tư tưởng và kiểm soát có thể giúp các phe nhóm nhỏ hoặc lãnh đạo chuyên quyền cố thủ quyền lực, với khả năng đảo ngược tình thế gần như không có.

Một ngày nào đó, các hệ thống AI tiên tiến có thể trở nên có ý thức. Nếu chúng ta thất bại trong việc công nhận — hoặc tính toán hợp lý — tư cách đạo đức của các thực thể kỹ thuật số, chúng ta có nguy cơ phạm phải những sai lầm nghiêm trọng về mặt đạo đức, có thể dẫn đến đau khổ hoặc bất công khổng lồ.

An toàn AI vẫn còn khá mới mẻ, và các hành động của bạn có thể có tầm ảnh hưởng đáng kể

Lời cảm ơn: Nội dung trang chủ được xây dựng dựa theo thông tin từ 80,000 Hours & AI Safety Atlas.

Ảnh bìa: Luis de la Torre-Ubieta, Fritzchens Fritz, Ariyana Ahmad & The Bigger Picture, LOC